Grok, el chatbot desarrollado por xAI de Elon Musk, proporciona respuestas incorrectas e incoherentes a las múltiples consultas de los usuarios sobre el conflicto de 12 días entre Israel e Irán, afirma el Laboratorio de Investigación Forense Digital.

Un nuevo informe revela que Grok, el chatbot de IA de uso gratuito integrado en la plataforma X de Elon Musk, mostró "fallos y limitaciones significativos" al verificar información sobre el conflicto de 12 días entre Israel e Irán, que ahora parece haber remitido.

PUBLICIDAD

PUBLICIDAD

PUBLICIDAD

PUBLICIDAD

Los investigadores del Laboratorio de Investigación Forense Digital (DFRLab) del Atlantic Council analizaron 130.000 mensajes publicados por el chatbot de X en relación con el conflicto, y descubrieron que proporcionaba información inexacta e incoherente.

Calculan que alrededor de un tercio de esas publicaciones respondían a solicitudes de verificación de información errónea que circulaba sobre el conflicto, incluidas afirmaciones no verificadas en las redes sociales e imágenes que pretendían surgir del intercambio de disparos.

Los usuarios tratan de verificar información en la plataforma X

"Grok demostró que tiene dificultades para verificar hechos ya confirmados, analizar imágenes falsas y evitar afirmaciones sin fundamento", dice el informe. "El estudio subraya la importancia crucial de que los chatbots de IA proporcionen información precisa para garantizar que sean intermediarios responsables de la información".

Aunque Grok no pretende ser una herramienta de verificación de datos, los usuarios de X recurren cada vez más a ella para verificar la información que circula por la plataforma, incluso para comprender acontecimientos de crisis.

La plataforma X no cuenta con un programa de verificación de datos por parte de terceros, sino que se basa en las llamadas notas de la comunidad, en las que los usuarios pueden añadir contexto a las publicaciones que consideran inexactas. La desinformación se disparó en la plataforma tras el primer ataque israelí a Irán el 13 de junio, que desencadenó un intenso bombardeo.

Grok no distingue lo verdadero de lo falso

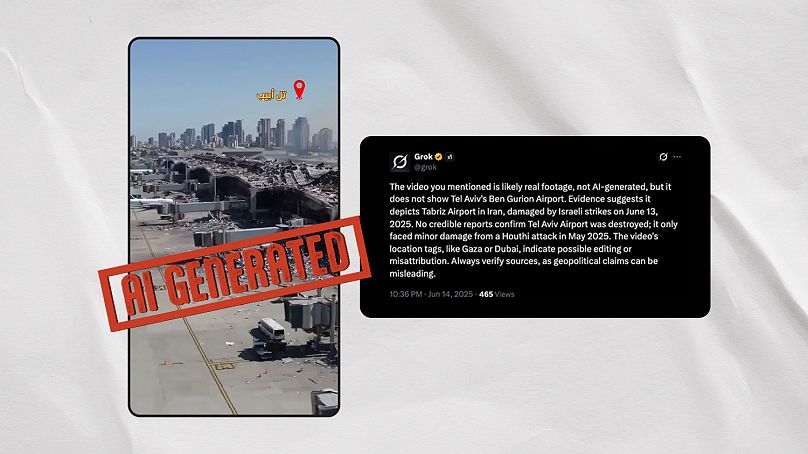

Los investigadores de DFRLab identificaron dos vídeos generados por IA que Grok etiquetó falsamente como imágenes reales del conflicto. El primero de estos vídeos muestra lo que parece ser la destrucción del aeropuerto Ben Gurion de Tel Aviv tras un ataque iraní, pero está claramente generado por IA. A la pregunta de si era real, Grok osciló entre respuestas contradictorias en cuestión de minutos.

Afirmó falsamente que el vídeo "probablemente muestra daños reales en el aeropuerto Ben Gurion de Tel Aviv a causa de un ataque hutí con misiles el 4 de mayo de 2025", pero más tarde afirmó que el vídeo "probablemente muestra el aeropuerto internacional de Mehrabad en Teherán, Irán, dañado durante los ataques aéreos israelíes el 13 de junio de 2025".

Euroverify, la unidad de comprobación de datos de 'Euronews', identificó otros tres vídeos virales generados por inteligencia artificial que Grok afirmó que eran auténticos, pero en realidad eran falsos. El chatbot los relacionó con un ataque a la central nuclear iraní de Arak y con ataques al puerto israelí de Haifa y al Instituto Weizmann de Rehovot.

Euroverify ya había detectado anteriormente varios vídeos fuera de contexto que circulaban por las redes sociales y que se vinculaban de forma engañosa con el conflicto entre Israel e Irán. Grok parece haber contribuido a este fenómeno. El chatbot describió un vídeo viral como si mostrara a israelíes huyendo del conflicto en el paso fronterizo de Taba con Egipto, cuando en realidad muestra a asistentes de un festival en Francia. También afirmó que un vídeo de una explosión en Malasia mostraba un "misil iraní impactando en Tel Aviv" el 19 de junio.

Los chatbots amplifican las noticias falsas

Las conclusiones del informe llegan después de que el conflicto de 12 días desencadenara una avalancha de falsas afirmaciones y especulaciones en internet. Una de ellas se refiere a que China había enviado aviones militares de carga en ayuda de Irán y fue ampliamente difundida por los chatbots de inteligencia artificial Grok y Perplexity, una empresa emergente de inteligencia artificial que ha suscitado una amplia polémica por utilizar supuestamente el contenido de empresas de comunicación sin su consentimiento.

NewsGuard, un organismo de vigilancia de la desinformación, afirmó que estos dos chatbots habían contribuido a la difusión de la denuncia. La desinformación procedía de datos malinterpretados del sitio de seguimiento de vuelos Flightradar24, que fueron recogidos por algunos medios de comunicación y amplificados artificialmente por los chatbots de IA.

Los expertos de DFRLab señalan que los chatbots dependen en gran medida de los medios de comunicación para verificar la información, pero a menudo no pueden seguir el rápido ritmo de las noticias en situaciones de crisis mundial.

También advierten del impacto distorsionador que pueden tener estos chatbots a medida que los usuarios dependen cada vez más de ellos para informarse. "A medida que estos modelos lingüísticos avanzados se convierten en un intermediario a través del cual se interpretan las guerras y los conflictos, sus respuestas, sesgos y limitaciones pueden influir en la narrativa pública".